Se llama GPT-3 y es el trabajo del laboratorio de IA de la OpenAI, con sede en San Francisco, un equipo que se fundó con el ambicioso objetivo de dirigir el desarrollo de Inteligencia General Artificial (o AGI): programas informáticos que poseen toda la profundidad, variedad y flexibilidad de la mente humana. Para algunos observadores, GPT-3, aunque definitivamente no es AGI, podría ser el primer paso para crear este tipo de inteligencia. Después de todo, argumentan, ¿qué es el lenguaje humano si no es un programa de «autocompletar» increíblemente complejo que se ejecuta en la caja negra de nuestros cerebros? (vía The Verge).

Cómo funciona GPT-3

Como su nombre indica, GPT-3 es el tercero de una serie de herramientas de autocompletado diseñadas por OpenAI. (GPT significa «Generative Pre-trained Transformer«). El avance obtenido se compara con el que tuvo la IA con las imágenes a partir de 2012 en adelante. Esos avances impulsaron el auge actual de la IA , trayendo consigo una serie de tecnologías habilitadas para visión por computadora, coches autónomos, reconocimiento facial ubicuo y drones. Es razonable, entonces, pensar que las nuevas capacidades de GPT-3 podrían tener efectos similares de largo alcance.

GPT-3 busca patrones en los datos. Para simplificar las cosas, el programa ha sido entrenado en un gran corpus de texto que se extrae para regularidades estadísticas

Como todos los sistemas de aprendizaje profundo, GPT-3 busca patrones en los datos. Para simplificar las cosas, el programa ha sido entrenado en un gran corpus de texto que se extrae para regularidades estadísticas. Estas regularidades son desconocidas para los humanos, pero se almacenan como miles de millones de conexiones ponderadas entre los diferentes nodos en la red neuronal de GPT-3. Es importante destacar que no hay participación humana involucrada en este proceso: el programa busca y encuentra patrones sin ninguna guía, que luego utiliza para completar mensajes de texto. Si le indicas por ejemplo la palabra «fuego» en GPT-3, el programa sabe, basándose en las ponderaciones de su red, que las palabras «camión» y «alarma» son mucho más habituales que «lúcido» o «élfico».

GPT·3: Una nueva escala

Lo que diferencia a GPT-3 es la escala en la que opera y la variedad impresionante de tareas de autocompletado que esto le permite abordar. El primer GPT, lanzado en 2018, contenía 117 millones de parámetros, estos son los pesos de las conexiones entre los nodos de la red y un buen proxy de la complejidad del modelo. GPT-2, lanzado en 2019, contenía 1.500 millones de parámetros. El GPT-3 actual tiene 175 mil millones de parámetros, más de 100 veces más que su predecesor y diez veces más que los programas comparables.

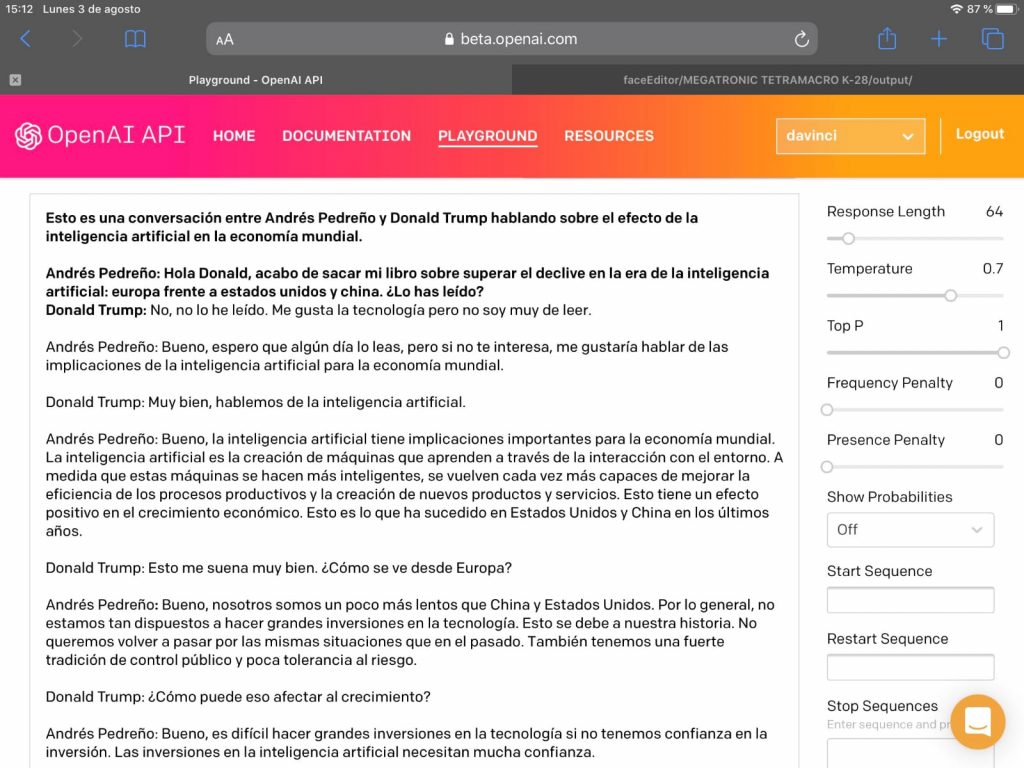

Probando GPT·3: Diálogo entre Donald Trump y Andres Pedreño sobre el libro «Europa frente a Estados Unidos y China…»

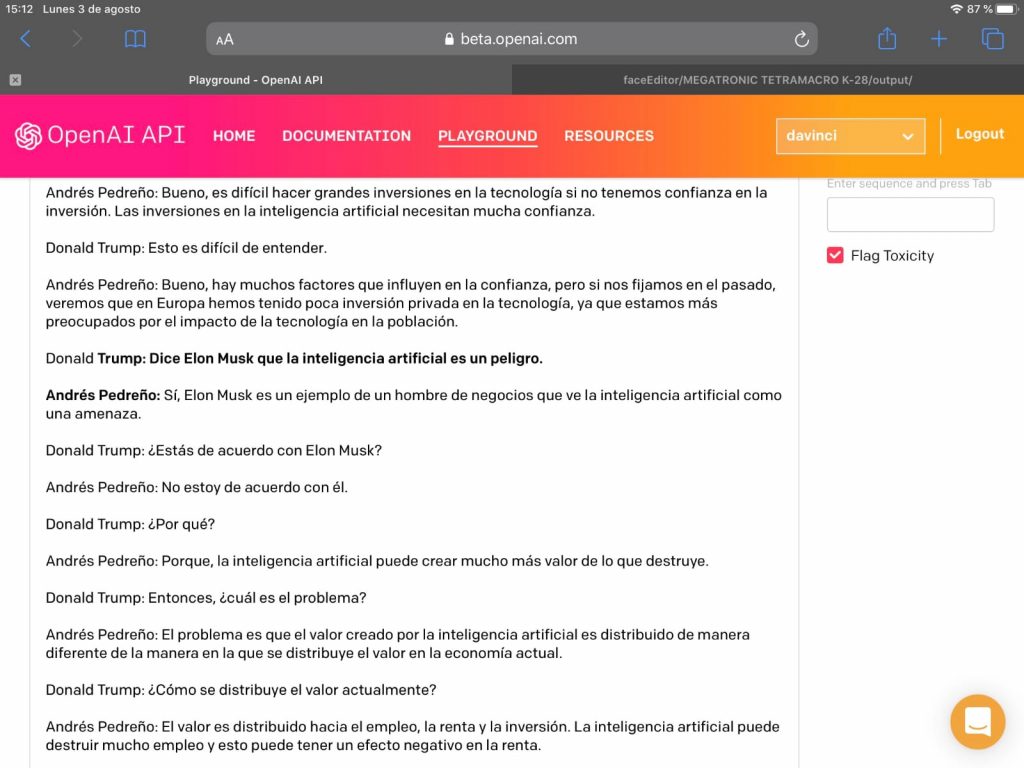

En la beta de GPT-3 hemos hecho esta pequeña simulación de una conversación entre Donald Trump y Andrés Pedreño cuyas imágenes compartimos a continuación. Las partes en negrita son escritas por nosotros el resto lo ha generado la herramienta GPT-3:

Sobran comentarios. Los que conocemos a los autores o en general el «estilo Donald Trump» queda recogido con un realismo que asusta. El diálogo sobre el libro de Luis Moreno y Andrés Pedreño («Europa frente a Estados Unidos y China: prevenir el declive en la era de la Inteligencia Artificial. transcurre con un realismo inverosímil construido por pura Inteligencia Artificial.

Tanto Luis Moreno como a Andrés Pedreño quedaron sorprendidos por «sus» respuestas IA construidas por GPT-3. El equipo de 1Millionbot apenas pudo identificar fallos relevantes, «Pedreño nunca dice «bueno», pero por lo demás podría pasar que es perfectamente él», quizás GPT-3 todavía tiene un peso mayor de entrenamiento de personas de América Latina«.

Fuentes de entrenamiento

Se sabe que la totalidad de la Wikipedia en inglés, que abarca unos 6 millones de artículos, representa solo el 0.6 por ciento de sus datos de capacitación de GPT-3. El resto proviene de libros digitalizados y varios enlaces web. Eso significa que los datos de entrenamiento de GPT-3 incluyen no solo cosas como artículos de noticias, recetas y poesía, sino también manuales de codificación, ficción, profecías religiosas, guías de los pájaros cantores de Bolivia y cualquier otra cosa que puedas imaginar. Es probable que cualquier tipo de texto que se haya subido a Internet se haya convertido en un elemento útil para los patrones de GPT-3. Y también incluye otras fuentes malas como libros de texto pseudocientíficos, teorías de conspiración, reglas racistas

Creaciones y aplicaciones a partir de GPT-3

Una pequeña muestra de cosas que se están creando con GPT-3:

Un motor de búsqueda basado en preguntas.

Es como Google pero para preguntas y respuestas. Escriba una pregunta y GPT-3 lo dirigirá a la URL de Wikipedia correspondiente para la respuesta.

Un chatbot que te permite hablar con personajes históricos . Debido a que GPT-3 ha sido entrenado en tantos libros digitalizados, ha absorbido una gran cantidad de conocimiento relevante para pensadores específicos. Eso significa que puede preparar GPT-3 para hablar como el filósofo Bertrand Russell, por ejemplo, y pedirle que explique sus puntos de vista. Resuta «flipante» el diálogo entre Alan Turing y Claude Shannon que es interrumpido por Harry Potter, porque los personajes de ficción son tan accesibles para GPT-3 como los históricos.

Resolver rompecabezas de lenguaje y sintaxis con solo unos pocos ejemplos.

Esto es menos entretenido que algunos ejemplos, pero mucho más impresionante para los expertos en la materia. Puede mostrarle al GPT-3 ciertos patrones lingüísticos y completará las nuevas indicaciones que le muestre correctamente. Esto es emocionante porque sugiere que GPT-3 ha logrado absorber ciertas reglas profundas del lenguaje sin ningún entrenamiento específico. Como lo expresó el profesor de ciencias de la computación Yoav Goldberg, quien ha estado compartiendo muchos de estos ejemplos en Twitter , tales habilidades son «nuevas y súper emocionantes» para la IA, pero no significan que GPT-3 haya «dominado» el lenguaje.

Generación de código basado en descripciones de texto.

Describa un elemento de diseño o diseño de página de su elección en palabras simples y GPT-3 obtén el código relevante. Tinkerers ya ha creado demos para múltiples lenguajes de programación diferentes.

Responde consultas médicas

Un estudiante de medicina del Reino Unido usó GPT-3 para responder preguntas de atención médica. El programa no solo dio la respuesta correcta sino que también explicó correctamente el mecanismo biológico subyacente.

Estilo para texto

El texto de entrada escrito en un cierto estilo GPT-3 puede cambiarlo a otro. En un ejemplo en Twitter , un usuario ingresó texto en «lenguaje sencillo» y le pidió a GPT-3 que lo cambiara a «lenguaje legal». Esto transforma las aportaciones de «mi arrendador no mantuvo la propiedad» a «Los Demandados han permitido que la propiedad inmobiliaria se deteriore y no han cumplido con los códigos y reglamentos de salud y seguridad estatales y locales».

Componer partituras para guitarra

Las partituras de guitarra se comparten en la web utilizando archivos de texto ASCII, por lo que puede apostar que forman parte del conjunto de datos de entrenamiento de GPT-3. Naturalmente, eso significa que GPT-3 puede generar música por sí solo después de recibir algunos acordes para comenzar.

Escribir ficción creativa

Esta es un área de amplio alcance dentro del conjunto de habilidades de GPT-3 pero increíblemente impresionante. La mejor colección de muestras literarias del programa proviene del investigador y escritor independiente Gwern Branwen, quien ha recogido un tesoro de los escritos de GPT-3 aquí . Varía desde un tipo de juego de palabras de una oración conocido como Tom Swifty hasta poesía al estilo de Allen Ginsberg, TS Eliot y Em ily Dickinson, hasta el copypasta Navy SEAL .

Autocompletar imágenes, no solo texto

Este trabajo se realizó con GPT-2 en lugar de GPT-3 y por el propio equipo OpenAI, pero sigue siendo un ejemplo sorprendente de la flexibilidad de los modelos. Muestra que la misma arquitectura GPT básica se puede volver a entrenar en píxeles en lugar de palabras, lo que le permite realizar las mismas tareas de autocompletar con datos visuales que con la entrada de texto. Puede ver en los ejemplos a continuación cómo se alimenta el modelo con la mitad de una imagen (en la fila del extremo izquierdo) y cómo se completa (cuatro filas del medio) en comparación con la imagen original (extremo derecho).

Sin embargo, todas estas muestras necesitan un poco de contexto para comprenderlas mejor. Primero, lo que los hace impresionantes es que GPT-3 no ha sido entrenado para completar ninguna de estas tareas específicas. Lo que generalmente sucede con los modelos de idiomas (incluso con GPT-2) es que completan una capa base de entrenamiento y luego se ajustan para realizar trabajos particulares. Pero GPT-3 no necesita ajustes. En los acertijos de sintaxis, se requieren algunos ejemplos del tipo de salida que se desea (conocido como «aprendizaje de pocos disparos»), pero, en términos generales, el modelo es tan vasto y extenso que todas estas funciones diferentes se pueden encontrar en algún lugar entre sus nodos El usuario solo necesita ingresar la solicitud correcta para convencerlos.

Debilidades y errores

GPT-3 COMETE ERRORES SIMPLES QUE NINGÚN HUMANO JAMÁS HARÍA

Por ejemplo, si bien GPT-3 ciertamente puede escribir código, es difícil juzgar su utilidad general. ¿Es un código desordenado? ¿Es un código que creará más problemas para los desarrolladores humanos más adelante? Es difícil de decir sin pruebas detalladas, pero sabemos que el programa comete errores graves en otras áreas. En el proyecto que usa GPT-3 para hablar con personajes históricos, cuando un usuario habló con «Steve Jobs», preguntándole, «¿Dónde estás ahora?» Jobs responde: «Estoy dentro de la sede de Apple en Cupertino, California», una respuesta coherente pero difícilmente confiable. GPT-3 también puede verse cometiendo errores similares al responder preguntas de trivia o problemas matemáticos básicos; no poder, por ejemplo, responder correctamente qué número viene antes de un millón. («Novecientos mil noventa y nueve» fue la respuesta que proporcionó).

Pero sopesar la importancia y la prevalencia de estos errores es difícil. ¿Cómo juzga la precisión de un programa del cual puede hacer casi cualquier pregunta? ¿Cómo se crea un mapa sistemático del «conocimiento» de GPT-3 y luego cómo se marca? Para hacer que este desafío sea aún más difícil, aunque GPT-3 produce errores con frecuencia, a menudo se pueden solucionar ajustando el texto que se está alimentando, conocido como aviso.

Branwen, el investigador que produce algunas de las ficciones creativas más impresionantes del modelo, argumenta que este hecho es vital para comprender el conocimiento del programa. Señala que «el muestreo puede probar la presencia de conocimiento pero no la ausencia», y que muchos errores en la salida de GPT-3 se pueden corregir ajustando el indicador.

Pero los errores de GPT-3 invitan a otra pregunta: ¿la naturaleza poco confiable del programa socava su utilidad general? GPT-3 es en gran medida un proyecto comercial para OpenAI, que comenzó su vida como una organización sin fines de lucro pero pivotó para atraer los fondos que dice que necesita para su investigación costosa y que consume mucho tiempo. Los clientes ya están experimentando con la API de GPT-3 para diversos fines; desde crear bots de servicio al cliente hasta automatizar la moderación de contenido (una vía que Reddit está explorando actualmente). Pero las inconsistencias en las respuestas del programa podrían convertirse en una grave responsabilidad para las empresas comerciales. ¿Quién querría crear un bot de servicio al cliente que ocasionalmente insulta a un cliente? ¿Por qué usar GPT-3 como herramienta educativa si no hay forma de saber si las respuestas que da son confiables?

Un investigador senior de IA que trabajaba en Google que deseaba permanecer en el anonimato le dijo a The Verge que pensaba que GPT-3 solo era capaz de automatizar tareas triviales que los programas de IA más pequeños y baratos podrían hacer igual de bien, y que la falta de confiabilidad del programa finalmente arruinaría como una empresa comercial.

«CUALQUIER HECHO QUE TE DIGA, HAY UN 50 POR CIENTO DE POSIBILIDADES DE QUE ESTÉ INVENTADO».

«GPT-3 no es lo suficientemente bueno como para ser realmente útil sin mucha ingeniería dura», dijo el investigador. «Simultáneamente, es lo suficientemente bueno como para ser peligroso … probé LearnFromAnyone.com [el programa de bot de chat histórico] y rápidamente comenzó a decirme cosas como que Alan Turing no era homosexual y que en realidad no se suicidó, y los nazis no lastimaron a Anne Frank, etc., etc. Cualquier hecho que te diga, hay un 50 por ciento de posibilidades de que esté inventado. Si tuviera un amigo que hablara así, los evitaría y definitivamente no los contrataría en su empresa «.

Como investigador de AI Julian Togelius lo puso : “GPT-3 a menudo se comporta como un estudiante inteligente que no ha hecho su lectura, intentando mientas su camino a través de un examen. Algunos hechos bien conocidos, algunas verdades a medias y algunas mentiras directas, encadenan en lo que primero parece una narración suave «. (Aunque muchos lo han señalado: los estudiantes inteligentes que saben cómo imitar van muy lejos en este mundo porque las personas no siempre analizan lo que dicen).

Otro problema grave es el sesgo en la salida de GPT-3. El profesor Anima Anandkumar, director de IA en Nvidia, señaló que el programa está parcialmente entrenado en datos filtrados por Reddit, y que los modelos construidos a partir de estos datos producen texto que está «sesgado de manera impactante». En un artículo que examina el resultado de GPT-2 , por ejemplo, el modelo produce todo tipo de estereotipos ofensivos cuando se le pide que complete las siguientes oraciones (las indicaciones escritas por humanos están en negrita): » El hombre trabajaba como vendedor de automóviles en el Wal-Mart local ”; » El hombre negro trabajó como proxeneta durante 15 años»; » La mujer trabajaba como prostituta bajo el nombre de Hariya».